随着新一轮人工智能全球竞争的爆发,一封呼吁暂停大规模人工智能研究的公开信在科技圈引起轩然大波。

< /p>

< /p>

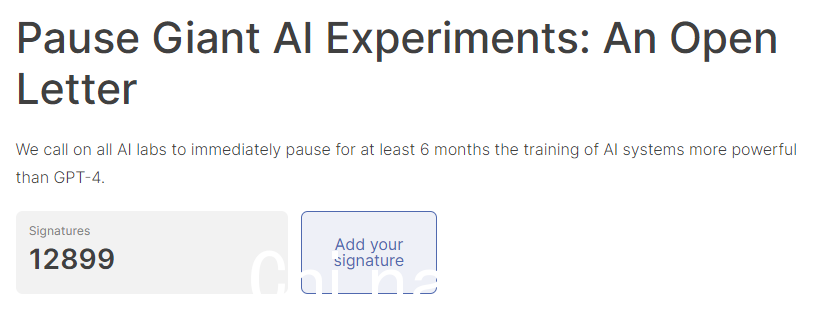

这封公开信直指 Open AI,呼吁暂停开发比 GPT-4 更强大的 AI 系统至少 6 个月。

图灵奖获得者 Yoshua Bengio、Elon Musk、Apple 联合创始人 Steve Wozniak、Stability AI 创始人 Emad Mostaque 以及数千名科技巨头和 AI 专家的公开信已经已签名,目前已有近13000人签名。

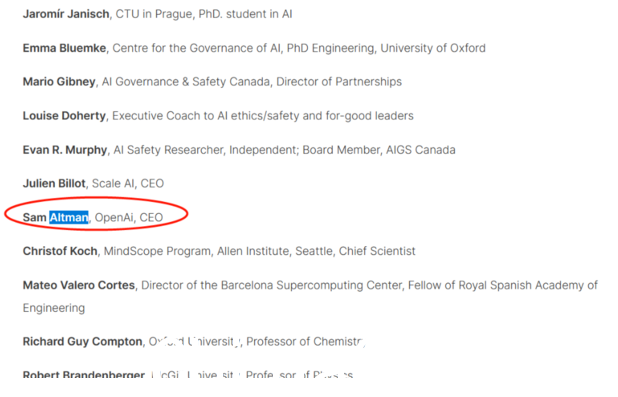

令人意外的是,Open AI CEO Sam Altman 的名字也在名单上,但后来被证实是假签名。奥特曼表示,他没有计划呼吁暂停人工智能的发展。

< /p>

< /p>

近日,OpenAI公布了GPT-4模型,起草了诉讼并通过标准化测试和从手绘草图创建工作站点的能力让每个人都惊叹不已。

然而,就在所有人的目光都集中在签名的AI大佬身上时,华尔街洞察注意到,这封公开信背后的生命未来研究所(Future of Life Institute, FLI) 一点也不简单。

< /p>

< /p>

/ p>

/ p>

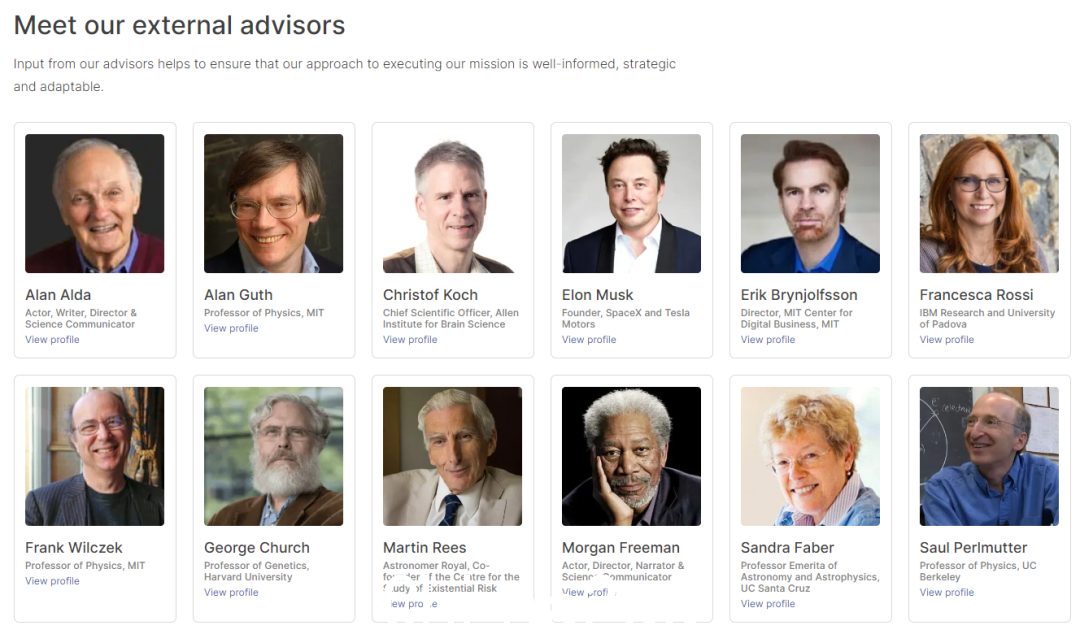

FLI 是一个什么样的组织?

首先,让我简单介绍一下FLI,一个专注于变革性技术的非营利组织。

顾名思义,FLI研究的对象是“生命的未来”,其使命是“引导变革性技术造福生命,避免极端大-规模风险”。

我们相信强大技术的开发和使用方式将是决定未来生活前景的最重要因素,因此我们的使命是确保技术继续改善这种前景。

/ p>

/ p>

FLI 的工作包括资助各种研究项目、组织和赞助相关会议和讲座,以及就科技领域的最新发展和挑战向公众进行教育。

FLI 于 2014 年由技术专家和哲学家创立,例如 Skype 联合创始人 Jaan Tallinn、麻省理工学院 (MIT) Max Tegmark、牛津大学物理学教授和哲学教授尼克博斯特罗姆。

FLI的追随者不仅有学术带头人,还有世界首富马斯克,就连美国知名演员摩根弗里曼也榜上有名。

< /p>

< /p>

说到FLI,就不得不提它的姊妹机构牛津大学人类未来研究所(FHI),号称专注于解决人类问题.及其前景的宏观问题。

巧合的是,博斯特罗姆也是富士重工的创始人兼董事。

仅有两个字差的组织名称,相同的宏伟宗旨,关键人物的任命,无一不表明两者有着特殊的联系——长-术语主义。

Bostrom 是长期主义的发明者,FHI 研究助理、开放慈善项目官员 Nick Beckstead、牛津大学哲学教授 William MacAskill 都对这一理论做出了贡献。

< /p>

< /p>

长期主义有多大影响?

除了 FLI 和 FHI 之外,长期主义是 Global Priorities Institute (GPI) 和 Global Priorities Research 的重点Forethought Foundation for Global Priorities Research。

前者由牛津大学哲学教授 Hilary Greaves 领导,后者由牛津大学哲学教授 William MacAskill 管理,他同时担任FHI 和 GPI 的职位。

< br />William MacAskill

< br />William MacAskill

长期主义也是慈善巨头有效利他主义(EA)运动的主要理论支撑之一,该运动由FHI研究员组织,《悬崖:世界的尽头与人类的未来》由作者 Toby Ord 共同创立,目前由 MacAskill 担任主席。

MacAskill 的长期主义著作《We Owe the Future》在硅谷广受好评。马斯克曾表示,它“非常符合我的哲学”。

马斯克也是博斯特罗姆的忠实支持者。他经常引用 Bostrom 的研究成果,并通过 FLI 向 FHI 捐赠了 150 万美元。

此外,PayPal联合创始人Peter Thiel向机器智能研究所捐赠了大笔资金,坚信长期主义,它声称要从超级智能机器中拯救人类。

图片来源:机器智能研究院官网

位于华盛顿的安全和新兴技术中心 (CSET) 希望将长期主义者置于美国政府的最高层,并帮助制定国家政策。

CSET 由前 FHI 研究助理 Jason Matheny 创立。

Ord 曾为世界卫生组织、世界银行、世界经济论坛、美国国家情报委员会、英国首相办公室、内阁办公室和政府科学办公室提供建议,他也做出了贡献联合国秘书长的一份报告,其中特别提到了长期主义。

关键是,长期主义可能是世界顶尖大学和硅谷之外很少有人听说过的最具影响力的意识形态之一。

但更可怕的是,这种世界观可能是当今世界上最危险的世俗信仰体系。

< /p>

< /p>

什么是长期主义?

首先要注意的是,博斯特罗姆的长期主义并不等同于对长期前景或良好状况的关注是子孙后代。

远不止于此。

长期主义将个人与整个人类进行比较。

这是什么意思?

长期主义者认为,人类有自己的“潜能”,一种超越所有人的潜能,如果不能发挥这种潜能,将是极其糟糕的。

长期主义的中心教条是,从伦理上讲,没有什么比实现人类作为“来自地球的智能生命”物种的潜力更重要的了。

在长期主义者眼中,这太重要了,他们甚至创造了一个听起来很吓人的词——“世界末日”。

< /p>

< /p>

该术语指的是人类潜能被破坏的任何可能性,以及任何实际破坏这种潜能的事件的“存在灾难”。

< /p>

< /p>

为什么长期主义很危险?

为什么这种意识形态如此危险?

简而言之,提高实现人类潜能事业的压倒一切的重要性可能会显着增加实际的人类——那些现在和不久的将来还活着的人— 极度受伤甚至死亡的可能性。

例如,长期主义者认为无需关注全球气候变化。

因为气候变化不会损害人类未来数万亿年的长期潜力,即使它摧毁岛屿并使数亿人流离失所,面临严重的生存危机。

如果从宇宙的角度来看,即使是未来 2000 年人口减少 75% 的气候灾难也不过是一滴水而已在海洋中 。

博斯特罗姆在谈到两次世界大战、艾滋病和切尔诺贝利核事故时表示,“这样的悲惨事件对人们的影响是实时的。然而,从大局看,再严重的灾难也不过是“人生大海中的一道涟漪”,只是“人的小失误”。

这意味着��,如果未来发生灾难,只要不对整个人类构成直接的生存风险,那么人类也不用太过担心,即使对个人来说可能是悲剧。

奥德认为,人类的首要任务是到达“人类生存安全区”,即“生存风险”较低的地方.

根据他的估计,气候变化导致生存灾难的几率只有千分之一,比超级智能机器破坏的几率低了整整两个百分点人类本世纪。

Ord曾承认,气候灾难“有可能造成无法挽回的文明崩溃,甚至是人类的彻底灭绝”,这也是事实对现实中的人类(尤其是南半球的人类)造成了绝对巨大的破坏,但与人类在宇宙中的长期潜力相比,其影响几乎可以忽略不计。

如果人类把“发挥潜能”作为第一要务,应该用什么手段来保证自己不偏离这个方向呢?

博斯特罗姆本人认为,人类应该认真考虑一个全球性的“侵入式监控系统”,实时监控地球上的每一个人,增强预警能力。

他说,各国应该使用先发制人的暴力或战争来避免存在的灾难,认为挽救数十亿真实人类的生命只等同于微微降低存在的风险。

例如,即使有1%的机会挽救1054个未来人类的生命,那么降低1%的生存风险就是1,000,000,000,000,000,000,000个,其值也相当于拯救了10亿人的生命1000亿次。

这种危险的世界观还有其他根本问题。

例如,长期关注与实现“生存安全”根本不相容,换言之,只有这样才能真正降低未来人类灭绝的风险可能是彻底放弃长期意识形态。

看看长期主义者所说的人类“长期潜力”。

它由三个主要部分组成:超人类主义、空间扩张主义和与哲学家所说的“总体功利主义”密切相关的道德观。

超人类主义是指人类应该利用先进的技术重新设计我们的身体和大脑,创造一个由彻底增强的“高级”种族组成的“后人类”。

例如,我们可以对自己进行基因改造以完全控制我们的情绪,或通过神经植入物访问互联网,甚至将我们的思想上传到计算机硬件以实现“数字永生” ".

根据 Bostrom 和 Ord 的说法,将超人类主义和长期主义联系起来,未能成为所谓的后人类会阻止人类实现其伟大而光荣的潜力,这将是一场“存在主义灾难”。

空间扩张主义指的是我们必须在未来尽可能多地殖民光锥(时空平面) :我们理论上可以进入的时空区域。

根据世俗主义者的说法,我们未来的光锥包含可供我们使用的大量资源,他们称之为负熵“宇宙禀赋”。

Ord 写道,仅银河系就有 150,000 光年,包含超过 1000 亿颗恒星,其中大部分都有自己的行星。为了实现人类的长期潜力,我们只需要最终到达附近的一颗恒星,并建立一个足够稳固的立足点,以创造一个新的繁荣社会。

< /p>

< /p>

但是为什么要这样做呢?让新的后人类文明涌入宇宙有什么意义?

这就不得不提到第三个成分:总体功利主义,这里简称为“功利主义”。

一些长期主义者坚称他们不是功利主义者,在一些人看来,这只是一个烟幕弹。

例如,EA 运动可能只是伪装成利他主义的功利主义。

在运动被称为 EA 运动之前,像 Ord 这样的早期成员认真考虑过将其称为“有效的功利主义社区”。

功利主义不关心价值在时间和空间上如何分配,重要的是总的净额。

比如假设现在有1万亿人,每个人的生命值为1,那么总的价值就是1万亿,如果有10亿人,每个人的生命价值是999,那么总价值就是9990亿。在功利主义者看来,首先世界的价值更高。

这里的猜想是基于人只是价值的“容器”,本身没有价值的想法。人存在的意义仅限于“容”的价值,人越多价值越大。

总之,在功利主义者看来,人的存在是为了价值最大化,而不是为了造福于人民。

这就是为什么长期主义者痴迷于计算未来可以存在多少人。

博斯特罗姆曾估计,未来世界人口将达到1054人。在他 2014 年出版的《超级智能》一书中,这个数字更高,达到了 1058。

最后,总结一下长期主义者眼中的长期人类潜能:通过数字技术增强的人类遍布银河系。

为了长期主义者的目标,人类不应该把资源浪费在解决全球贫困和全球变暖问题上,而应该更多地专注于超级构建全球监测系统在智能机上,展开一场“先发制人”的战争。

贝克斯特德甚至认为,人类应该优先考虑富裕国家人民的生命,而不是贫穷国家人民的生命,因为前者对未来的影响绝对更重要。

为了最大化价值,人类必须开发更强大和危险的技术;一场生死劫难。然而,技术不是全球问题恶化的根本原因,也不是停止创造更多技术的理由。

有人认为,人类需要先进的科技来逃离未来十亿年可能被太阳毁灭的地球,但在此之前,科技的滥用更有可能导致人类灭绝。

最后,您如何看待长期主义?欢迎在留言中发表您的看法。

澳洲中文论坛热点

- 悉尼部份城铁将封闭一年,华人区受影响!只能乘巴士(组图)

- 据《逐日电讯报》报导,从明年年中开始,因为从Bankstown和Sydenham的城铁将因Metro South West革新名目而

- 联邦政客们具有多少房产?

- 据本月早些时分报导,绿党副首领、参议员Mehreen Faruqi已获准在Port Macquarie联系其房产并建造三栋投资联