随着以ChatGPT为代表的生成式AI的兴起,其背后基于大模型的人工智能成为行业投资方向。

所谓的“大模型”通常是在一个没有标签的大数据集上通过自监督学习来训练的。

在其他场景的应用中,开发者只需要对模型进行微调,或者使用少量数据进行二次训练,即可满足需求新的应用场景需要。

据腾讯研究院介绍,目前人工智能大多是针对特定场景应用进行训练,生成的模型很难迁移到其他应用,属于属于“小机型”范畴。

整个过程不仅需要大量的人工调参,还需要将大量的标注数据馈送给机器,减少了研究和人工智能的开发效率高,成本也比较高。高的。

相比之下,大模型的改进可以惠及所有下游小模型,大大提升人工智能的使用场景和研发效率。

同时在大模型的框架下,ChatGPT使用的GPT模型每一代的参数都有高速扩展,并且预训练的数据量要求和成本也在快速提升。

GPT-3 训练一次大约需要 140 万美元,一些更大的 LLM 模型需要 200 万到 1200 万美元。

这个成本对于全球科技巨头来说并不便宜,但还在可以接受的范围内。

/ p>

/ p>

初期投资近十亿美元,每天电费数万美元

国盛证券预计,今年1月平均每天有1300万独立访问者使用ChatGPT,对应芯片需求超过3万颗Nvidia A100 GPU,初始投资成本约8亿美元,每天电费5万美元左右:

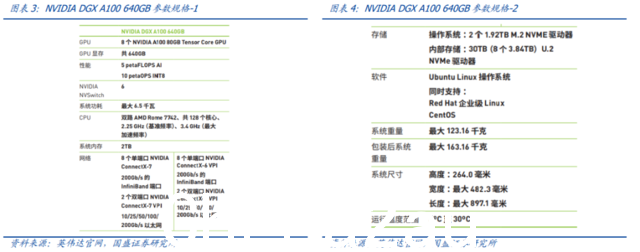

1)计算假设:NVIDIA A100:根据OneFlow报告目前,NVIDIA A100 是 AWS 性价比最高的 GPU 选择。

NVIDIA DGXA100服务器:单机搭载8块A100GPU,AI运算性能约5PetaFLOP/s,单机最大算力机器约6.5kw,价格约19.9万美元/台。

标准机柜:19英寸,42U。

单台DGXA100服务器的尺寸约为6U,一个标准机柜可放置7台左右的DGXA100服务器。

那么,单个标准机柜成本140万美元,56个A100GPU,计算性能35PetaFLOP/s,最大功率45.5kw。

2)芯片需求:日咨询量:根据Similarweb数据,截至2023年1月末,chat.openai.com网站(即ChatGPT官网)在2023/1/27-2023/2/3这一周吸引了多达2500万的日访问量。

假设在当前稳定状态下,每个用户每天提问10个左右,每天咨询量约2.5亿次。

A100跑分:假设每道题平均30个词,单个词在A100GPU上消耗350ms左右,一共消耗729,167 A100GPU 每天运行小时数。

A100需求:对应的,需要729,167/24=30,382个Nvidia A100GPU每天同时计算才能满足当前的ChatGPT访问量。

3)运营成本:初始算力投入:基于上述NVIDIA DGXA100,需要30,382/8=3,798台服务器,对应3,798/7=542台内阁。

为满足ChatGPT目前数千万用户的咨询量,初期算力投入成本约为542*140=7.59亿美元。

每月电费:以用电量计算,542*45.5kw*24h=591,864kwh/天。参考 HashrateIndex 统计数据,我们假设美国的平均工业电价约为 0.08 美元/千瓦时。

那么,每天的电费约为 2,369,640*0.08=47,000 美元/天。

训练成本:公有云,单子-百万到数千万美元

国盛证券根据参数数量和代币数量估算,成本一次 GPT-3 培训的费用约为 140 万美元;对于一些较大的��LLM模型使用相同的计算公式,训练成本在200万美元到1200万美元之间:

1) 基于参数个数和token的数量,据OneFlow估计,GPT-3训练一次的成本约为139.8万美元:通常每个token的训练成本约为6N(推理成本约为2N),其中N为数量LLM的参数;假设在训练过程中,模型的FLOPS利用率为46.2%,与在TPUv4芯片上训练的PaLM模型(5400亿参数)一致。

2)对于一些更大的LLM模型(比如2800亿参数的Gopher和5400亿参数的PaLM),使用同样的计算公式,可以得出培训成本在200万到1200万美元之间。

国盛证券认为,在公有云上,对于谷歌这样的全球科技公司来说,数百万至数千万美元的培训成本并不便宜,但可以接受且不贵。

澳洲中文论坛热点

- 悉尼部份城铁将封闭一年,华人区受影响!只能乘巴士(组图)

- 据《逐日电讯报》报导,从明年年中开始,因为从Bankstown和Sydenham的城铁将因Metro South West革新名目而

- 联邦政客们具有多少房产?

- 据本月早些时分报导,绿党副首领、参议员Mehreen Faruqi已获准在Port Macquarie联系其房产并建造三栋投资联