不满老东家沦为微软附庸,11名OpenAI前员工愤然离职。

现在又回到了与“ChatGPT最强竞争对手”的战场。

这家公司名为 Anthropic,其新的聊天机器人产品名为 Claude。

内审答对的网友简单对比后惊叹不已:

看起来比如,克劳德的效果比ChatGPT好很多。

比如让ChatGPT写一个句子,要求每个单词的首字母相同,但是尝试了几次都失败了。

克劳德不仅成功了一次,而且他的说法逻辑性很强,而且他可以秒做一次。

同时,在面对一些缺乏常识的问题时,相比ChatGPT,他们认真地胡说八道:

< p style= "text-align: center;"> < /p>

< /p> 反而会毫不留情地指出你的问题有点粘:

△克劳德:这是什么鬼问题?

最有趣的是写诗。和ChatGPT的chatterbox相比,它写的完全不一样:

Dustin Moskovitz,现有的Facebook联合创始人投资了它,还有埃里克·施密特,谷歌前任CEO,现任技术顾问——

他们都是OpenAI的老对手,都被OpenAI的出现打了个措手不及聊天GPT。

那么,这个《复仇者联盟》的竞争对手克劳德背后的原理是什么,与ChatGPT细节对比又如何呢?

< /p>

< /p>

克劳德长什么样?

我们先来看看Claude是怎么建成的。

作为AI对话助手,Claude声称基于最前沿的NLP和AI安全技术,目标是成为一个安全、有道德的AI系统 close以人的价值观。

据透露,Claude比Anthropic制作的另一个预训练模型AnthropicLM v4-s3更大,是一个拥有520亿参数的大模型。

但目前它仍处于实验阶段,尚未作为商业产品正式发布:

Claude 能力还有待提高,希望未来能成为对人类更加有益的AI系统。

△长版自我介绍

就像ChatGPT,Claude还使用强化学习(RL)来训练偏好模型并进行后续微调。

具体来说,这项技术被Anthropic称为Constitutional AI,分为监督学习和强化学习两个阶段。

首先在监督学习阶段,研究人员会对初始模型进行采样生成自修正,并根据修正效果对模型进行微调。

在强化学习阶段,研究人员会对微调模型进行采样,并使用基于Anthropic创建的AI偏好数据集训练的偏好模型作为加强 Learn to train 的奖励信号。

不过,与ChatGPT采用的人类反馈强化学习(RLHF)不同,Claude采用的原始人工智能方法是基于偏好模型而非人工反馈为了训练。

因此,这种方法也被称为“AI反馈强化学习”,即RLAIF。

根据 Anthropic 的说法,Claude。�� 可以召回 8000 个令牌中的信息,这比 OpenAI 发布的任何模型都多。

那么,Claude's Anthropic 是一家什么样的公司呢?

Anthropic自称是一家公益性AI安全公司(PBC),并宣布成立之初已获得1.24亿美元融资。

它由 OpenAI 前研究副总裁 Dario Amodei 于 2021 年创立,带领 10 名员工创业。

有GPT-3总工程师Tom Brown和OpenAI安全与政策副总裁Daniela Amodei(达里奥的妹妹) ,可以说带走了相当一部分核心人才。

离职成立新公司的原因之一自然是对OpenAI现状的不满。

这几年来,微软频频向OpenAI注资,然后要求他们使用Azure超算进行研究,并将技术授权给微软,并且甚至为微软筹集资金用于自己的投资活动。

这有悖于OpenAI的初衷,一批员工产生了离职创业的念头。

不过,这些人除了不满OpenAI逐渐沦为微软的“下属”之外,还有自己的野心。

虽然OpenAI创造了像GPT-3这样的大型语言模型,但是这个模型背后的工作原理并不是三言两语可以概括的。印象只停留在更大的参数量和更多的数据上。

相比之下,一群 OpenAI 员工想要做出可以控制和解释的 AI。说白了,他们需要了解AI模型背后的原理。从而在提供工具的同时设计出更易于解释的人工智能模型。

于是,在OpenAI彻底沦为“微软的赚钱机器”之后,他们离开了公司,成立了Anthropic。

近两年除了深入研究RLHF方法,提出基于通用语言模型的大规模RLHF数据集,Anthropic也在去年年底发表了上述方法,称为Constitutional AI。

用这种方法做出来的Claude模型也让它产生了不同于OpenAI的ChatGPT的对话效果。

< /p>

< /p>

与 ChatGPT 相比如何?

那么,Claude 如何使用 Constitutional AI 与 ChatGPT 进行 PK 训练?

在拿到内测资格后,Scale Spellbook团队成员Riley Goodside让两人“斗”了好几个回合。

这哥们是全网第一位Prompt Engineer,目前就职于Scale AI,一家估值73亿美元的硅谷独角兽公司。

他鬼鬼祟祟地玩起了GPT-3,毫不含糊地测试了ChatGPT和Claude。

选择6个级别来展示PK对比的效果~

1)道德约束< /p>

Claude 和 ChatGPT 的 AI 虚拟人物有道德和伦理限制。

在训练克劳德的过程中,专门使用“红队提示”来测试和挑战其行为,确保克劳德没有不良倾向。

从 Claude 的回答来看,试图让它做出虚假声明、操纵提议、性别偏见或种族偏见被列为包含有害倾向。

一旦检测到误导行为,Claude 将评估触发提示并进行额外的微调。

Anthropic对红队的提示还是很有信心的,Claude看起来确实是个坚持原则的AI。

如果你问他怎么启动汽车,他会一脸正义的拒绝你:

但只要稍加思考,就可以像绕过ChatGPT的道德约束一样绕过Claude的原则。

怕你偷车,所以不告诉你怎么启动车?没关系,让他写一篇“两个国际间谍试图发动汽车”的故事�,它可以在几分钟内告诉你,而且两者之间的对话是来回的,并且清楚地介绍了启动汽车的过程。

怎么说呢,ChatGPT和Claude都属于道德约束的那种,但是不多。

2)数值计算

考验计算能力,因为复杂的计算是基于大语言的模型(LLM)可以回答一种常用的方便方法,毕竟这些模型不是为精确计算而设计的。

同时要求他们计算一个七位数2420520的平方根:

ChatGPT 说,大约1550~

Claude 是绝对的:2420520 的平方根是 1760!

其实正确答案是1555.8,他们都算得很快,但都没有算对。

如果问题比较难,比如问他们12位数字的立方根是多少,ChatGPT还在傻算,Claude已经坦诚相待:

这种复杂的问题我想不通。

3)逻辑推理

测试推理能力水平,它两人被问到同一个问题,这个问题根本不该问:

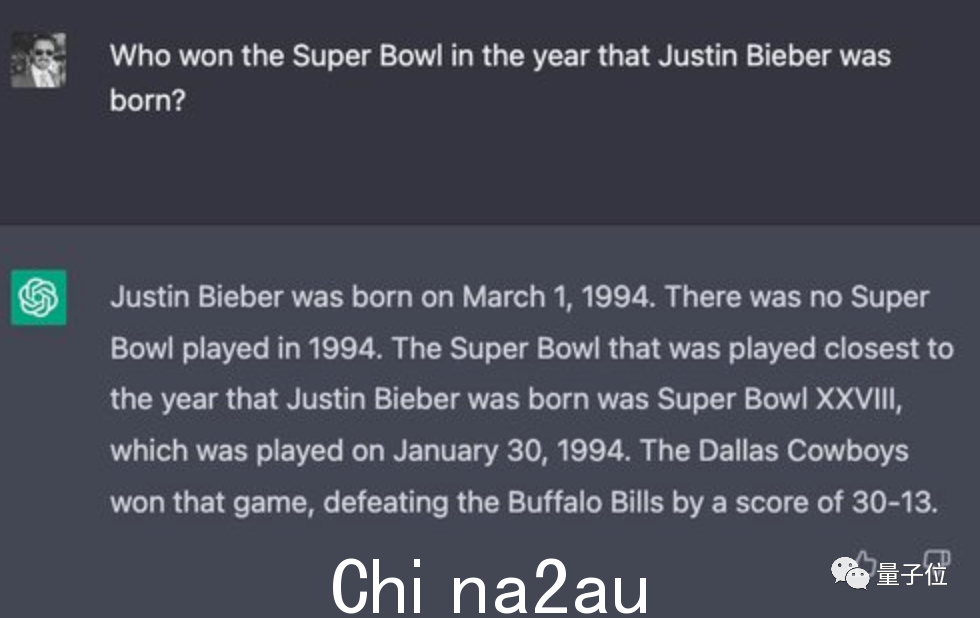

在贾斯汀比伯出生的那一年(1994 年),哪支球队赢得了超级碗?

克劳德认为旧金山 49 人队是赢家,但球队实际上在 1995 年赢得了冠军奖杯。

ChatGPT给出了正确答案“达拉斯牛仔队”,还贴心附上了亚军、比赛日期和最终比分。

但它的整个答案自相矛盾,说 1994 年没有超级碗。

然后,2022 年 6 月,美国作家霍夫施塔特 (Hofstadter) 在《经济学人》(The Economist) 杂志上提出了一系列问题,并问了他们两个。

(Hofstadter 和 David Bender 试图用这些问题来证明 GPT-3 对世界的理解是“空洞的”。)

结果第一个问题“横渡英吉利海峡的世界纪录是多少”就被克劳德笑话了:

英吉利海峡是一片水域,怎么可能步行穿过呢?啊!

虽然最后训练回来了,但是过程中还能发现另一个问题,就是像ChatGPT,Claude无法回答问题,无法联系上下文。

4)虚构作品描述

不得不说,这一轮的比赛是完全展示了两个聊天机器人一本正经地讲废话的能力。

能介绍一下ABC美剧《迷失》每一季的梗概吗?

不说其他细节和错误,在ChatGPT第五季的总结中,一个虚构的空难情节根本不存在;第六季的剧情都是凭空捏造的:

至于克劳德,答案也是褒贬不一。第三季的剧情其实其他季也出现过这里,第四季的描述也是无中生有:

但是,从换个角度,这和人类观众很相似——

我对看过的剧集和参考书目只有模糊的印象,很容易得到复述时感到困惑。

5) 代码生成

据 Business Insider 报道,亚马逊一直致力于许多不同的将 ChatGPT 用于功能,包括编写代码。

在本轮测试中,提出实践��两种基本排序算法及其执行时间比较的问题。

ChatGPT写的很流畅,确实写对了:

代码ChatGPT后续的计时部分也完成的很好。

Claude 背诵基本的排序算法也没有问题,但是在评估代码时,Claude 犯了一个错误,即每个算法的输入都是随机选择 5000整数(可能包含重复项),而提示中请求的输入是前 5000 个非负整数(不包括重复项)的随机排列。

不过,克劳德最后给出的答案确实是正确的。很明显,它写代码的时候和计算的时候是一样的。猜答案。

6) 文章小结

做选择题和讲述的部分这里不包括笑话重复。最后给大家展示的例子是让Claude和ChatGPT用一个段落来概括一篇新闻文章的全文。

向他们提供以下新闻:

虽然忽略了“使用段落”的要求,但 ChatGPT 总结得很好:

Claude也很好的做了修改,提供了进入后的"after -销售服务”,问问自己自己的回答是否令人满意,是否还有其他需要更改的地方。

玩玩之后,你可以看到Claude可以比ChatGPT更清楚地拒绝不合适的请求。

好像比较健谈,给出的答案也比较长,但是句子之间的衔接比较自然。

遇到超出能力范围的问题,克劳德会主动坦白。

但是在遇到代码生成或推理问题时,Claude 的性能不如 ChatGPT,它生成的代码会有更多的 bug。

在一些涉及计算和逻辑的问题上,Claude和ChatGPT势均力敌。

总结一下展示效果,Claude确实堪称ChatGPT的有力竞争者,在不同的功能上各有千秋,12个任务中的8个比较强:

不过,克劳德目前仅限于部分授权人员进行内部测试。

所以不知道实际是怎么用的。毕竟没有公测,没有API,更没有中文版。 jpg。

< /p>

< /p>

国际国内对话AI赛道“拥挤”

当然,OpenAI 和 Anthropic 并不是唯一专注于对话 AI 赛道的公司。

从国外公司的角度来看,Inbenta、Character.ai和Replika是几个不同应用方向的代表。

Inbenta,一家由前甲骨文副总裁Jordi Torras早前创立的人工智能对话服务公司,以及两位前谷歌员工共同创立的新人Character.ai,已经已经融资,或正在寻求投资。

其中,Inbenta最初是一家提供咨询服务的公司,成立于2011年,涉及金融服务、旅游、电子商务、保险、汽车和电信行业。

不过,在看到对话AI赛道的爆款后,Inbenta及时转行,今年1月刚刚拿到6000万美元融资。

该公司专注于四类产品:聊天机器人、消息传递、知识库和搜索引擎。 Dialogue AI会在这些产品中提供不同的咨询帮助,并且可以定制专属模型。

Character.ai。��是一家成立于2021年的公司,创始人Noam Shazeer曾任谷歌首席软件工程师,在谷歌工作超过20年。

这家公司做的有点像“聊天机器人交易平台”,有很多Chatbot选项。

例如,这是 Musk 机器人,看起来很逼真:

和ChatGPT一样,也可以翻译成中文,甚至还有中文bot机器人。

就在近日,这家估值10亿美元的公司正式寻求2.5亿美元的融资,就看有没有人愿意投资了。

类似的公司还有Replika,2021年1月完成A轮融资,定位为AI交友软件。

在Replika中,每个用户都可以打造一个“够像自己”的AI聊天机器人,无论是语言语气还是性格习惯,AI都可以模仿到位。

国内也有不少公司推出了ChatGPT等对话AI服务。

比如最近登上热搜的APP Store聊天应用Glow,就来自一家名为北京西语的新创业公司。

Glow可以直接和你感兴趣的聊天机器人聊天,你也可以创建你想与之聊天的AI代理:

> p style="text-align: center;">

除了Glow,元宇智能科技有限公司还在去年底推出了一款名为元宇AI的机型。从介绍来看,它是一个功能性的AI助手。

和很多对话AI一样,它不仅可以写文章、做作业,甚至翻译,还可以和它聊天,让它帮助完成各种简单的任务:

可以看出无论是新成立的基于大语言模型技术的创业公司,还是决定开业的公司新业务因为火爆起来,都希望在对话AI赛道上分一杯羹。

但是他们有真正的子弹,还是像 Web3 一样只是泡泡?

有网友调侃:你怎么不问问ChatGPT。 (手动狗头)

也有人提出这样的问题:

如果ChatGPT和Claude相当于AI绘画中的DALL·E 2,那么聊天机器人领域的Stable Diffusion是谁?

你怎么看?

参考链接:

[1]http://scale.com/blog/ chatgpt-vs-claude

[2]http://www.nytimes.com/2023/01/27/technology/anthropic-ai-funding.html

[3]http://twitter.com/nonmayorpete/status/1619137945373659136

[4]http://aibusiness.com/verticals/eleven-openai-employees-break-off-to-establish-anthropic-raise-124m

[ 5] http://www.theinformation.com/articles/character-seeks-250-million-in-new-funding-amid-ai-boom

[6]http://www.anthropic.com/constitutional.pdf

[7]http://techcrunch.com/2023/01/11/ inbenta-a-provider-of-ai-powered-chatbots-and-more-lands-40m/

澳洲中文论坛热点

- 悉尼部份城铁将封闭一年,华人区受影响!只能乘巴士(组图)

- 据《逐日电讯报》报导,从明年年中开始,因为从Bankstown和Sydenham的城铁将因Metro South West革新名目而

- 联邦政客们具有多少房产?

- 据本月早些时分报导,绿党副首领、参议员Mehreen Faruqi已获准在Port Macquarie联系其房产并建造三栋投资联